За останні шість років технологія штучного інтелекту набула величезної популярності. Розробки у цій сфері можуть зробити революцію та змінити наше повсякденне життя. На тлі ажіотажу навколо ШІ також висловлюються побоювання щодо етичних наслідків його розвитку.

На думку деяких експертів, ризики не обмежуються потенційними дезінформаційними атаками і виходять за межі генеративних сервісів, поширюючись чи не на всі сфери діяльності людини.

Видання ForkLog розглянуло основні концепції етичного ШІ та його безпечність.

- Дебати про етику штучного інтелекту продовжуються з моменту появи технології.

- Алгоритми, які взаємодіють із людьми, необхідно перевіряти на наявність ризиків відповідно до загальноприйнятих норм моралі.

- Штучний інтелект не потрібно робити схожим на людський.

- Вчені, техгіганти та уряди сходяться в основних принципах етичного ШІ.

Визначення етики ШІ та історія терміну

Сама собою етика — філософська дисципліна, що досліджує моральність і мораль. Інакше кажучи, вона пояснює, що таке добре, а що таке погано.

Етика штучного інтелекту, у свою чергу, є сукупністю принципів відповідального ШІ — як він має чинити, а як не повинен. Ці принципи часто мають на увазі безпеку, справедливість та орієнтованість на людину.

Одними з перших тему «машинної моралі» порушили письменники, які працюють у жанрі наукової фантастики. У своїх творах вони міркували про поведінку роботів, їх розум, почуття і взаємодію з людиною. Ця течія отримала назву «робоетика».

Популяризатором явища вважається Айзека Азімова — автора оповідання «Хоровод». У ньому письменник уперше сформулював «Три закони робототехніки». Пізніше у романі «Роботи та імперія» Азімов доповнив список нульовим правилом. Вони звучать приблизно так:

- Робот не може своєю дією завдати шкоди людству, або ж внаслідок бездіяльності допустити, щоб людству було завдано шкоди.

- Робот не може своєю дією завдати шкоди людині, або ж внаслідок бездіяльності допустити, щоб людині було завдано шкоди.

- Робот повинен підкорятися наказам людини, за винятком випадків, коли ці накази суперечать Першому закону.

- Робот повинен захищати свою безпеку доти, доки вона не суперечить Першому чи Другому закону.

Закони Азімова набули популярності і вийшли далеко за межі його літературних творів. Їх досі обговорюють письменники, філософи, інженери та політики.

На думку низки критиків, подібні норми важко реалізувати практично. Фантаст Роберт Сойєр заявив, що бізнес не зацікавлений у розвитку корінних заходів безпеки.

Проте трансгуманіст Ганс Моравек має протилежну думку. За його словами, корпорації, які використовують роботи на виробництві, можуть використовувати «складний аналог» цих законів для управління технічним процесом.

Сформульовані Азимовим правила використовували і урядові структури. У 2007 році влада Південної Кореї розробила «Статут етичних норм для роботів». Основні положення документа нагадують викладені письменником постулати.

У зв’язку із застосуванням роботів у військовій сфері проблема стала більш актуальною. У 2021 році ООН вперше зафіксувала вбивство людини дроном зі штучним інтелектом, який самостійно визначив ціль, вистежив її та ухвалив рішення про ліквідацію.

Після популяризації генеративних алгоритмів на кшталт GPT чи DALL-E дискусії про етику штучного інтелекту розширилися. Уряди країн обговорюють потенційні ризики та розробляють плани регулювання технології ШІ, а техгіганти активно розвивають внутрішні команди для створення безпечного ШІ.

«Проблема вагонетки»

Розвиток технологій, що прямо впливають на життя людей, породжують цілу низку етичних та моральних дилем. Найяскравіше їх можна описати на прикладі безпілотних автомобілів: як має вчинити робокар в екстреній ситуації? Поставити під загрозу життя пасажира чи пішохода?

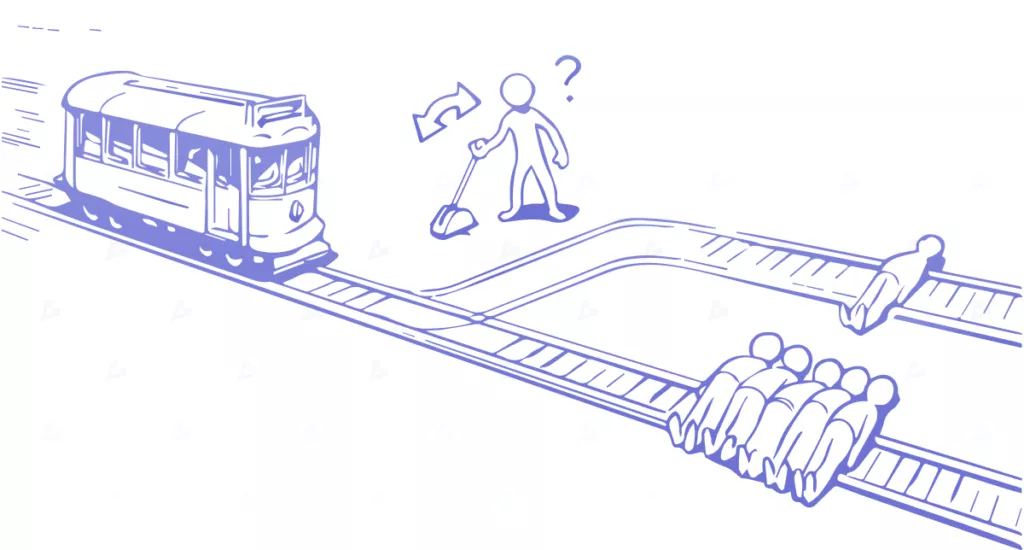

Цю дилему добре ілюструє «проблема вагонетки», яку у 1967 році сформувала англійська філософіня Філіпа Фут. Загальний зміст завдання звучить так:

«Вагонетка втратила керування і мчить по залізничній колії. Попереду на коліях прив’язано та знерухомлено п’ятьох людей. Ви стоїте на певній відстані від місця подій біля стрілки. Якщо ви переведете стрілку, вагонетка промчить по сусідній колії, проте там прив’язана одна людина.

Ви не маєте можливості вплинути на ситуацію. Є тільки два варіанти: нічого не робити, і вагонетка уб’є п’ятьох людей, або перевести стрілку і пожертвувати одним життям. Який варіант правильний?

Більшість моральних принципів можна переформатувати у схожі завдання та провести низку експериментів. У реальному житті може виявитися набагато більше варіантів, а наслідки менш трагічними. Однак зроблений ШІ вибір так чи інакше впливатиме на життя, і виключати всі ризики не можна.

ШІ не повинен вчитися у людей

Незважаючи на те, що моральні та етичні принципи формує людина, ШІ не повинен бути схожим на людей, оскільки в алгоритм можуть проникнути властиві суспільству упередженості.

Це добре ілюструє технологія розпізнавання облич. Для створення релевантних систем збирають великий набір даних із зображенням людей. Часто за процесом стоять автоматизовані боти, які не враховують різноманітність вибірки та контекст. В результаті датасет спочатку може виявитися упередженим.

Наступний етап розробки — побудова моделі та тренування. На цій стадії також можуть проникнути упередження та спотворення, у тому числі через проблему «чорної скриньки». Інженери просто не знають, чому алгоритм виносить те чи інше рішення.

Ризики упередженості існують лише на рівні інтерпретації. Однак на цьому етапі вже більшу роль відіграє людина. Наприклад, алгоритм навчили на певній вибірці людей та отримали конкретні результати. Потім застосували систему до іншої групи — дані кардинально змінилися.

2021 року нідерландські активісти довели наявність спотворень у системі розподілу соціальної допомоги. За їх словами, її використання порушувало права людини. В результаті муніципальна влада відмовилася від експлуатації ПЗ.

Про проблему з перенесенням даних повідомляють і розробники. У березні 2023 року група дослідників розробила алгоритм, який прогнозує ризик появи раку підшлункової залози. Для навчання системи дослідники переважно використовували медичні записи пацієнтів датських клінік.

Вчені попередили, що точність алгоритму при проектуванні на пацієнтів із США значно знижується. Через це алгоритм слід перевчити на даних американців.

Популярні принципи етичного ШІ

Дослідницькі групи, правозахисники, техгіганти та уряди пропонують різні підходи, проте всі вони мають низку подібностей. Розглянемо найпопулярніші думки.

Справедливість та недискримінація

Системи штучного інтелекту необхідно розробляти таким чином, щоб звести до мінімуму дискримінацію за ознакою раси, статі, релігії чи інших захищених характеристик. Упередження в алгоритмах можуть зміцнити існуючу нерівність і завдати шкоди певним групам.

Наприклад, системи розпізнавання осіб показали упередженість у своїй точності з вищим рівнем помилок для певних расових та гендерних груп. У 2019 році темношкірий житель штату Нью-Джерсі (США) провів 10 діб у в’язниці через помилку алгоритму. Подібні випадки траплялися і в інших містах , за що поліція зіткнулася з хвилею критики через використання необ’єктивних технологій.

Етичні методи ШІ можуть допомогти виявити та пом’якшити такі упередження, сприяючи справедливості при прийнятті рішень.

Прозорість і зрозумілість

Прозорість та зрозумілість мають вирішальне значення для зміцнення довіри до ШІ. Системи необхідно створювати таким чином, щоб їх процеси та результати прийняття рішень були зрозумілі всім заінтересованим сторонам.

Розробники генеративних систем розглядають можливість застосування водяних знаків для маркування контенту, створеного алгоритмами. Вони вважають, що це підвищить обізнаність користувачів і запобігатиме поширенню дезінформації.

Іншим прикладом прозорого використання ШІ є закон штату Іллінойс (США) щодо конфіденційності біометричних даних. Документ забороняє підприємствам використовувати технології на кшталт розпізнавання облич без явного повідомлення користувачів.

У рамках закону компанії на кшталт Google та Clearview AI вже зіткнулися з багатомільйонними штрафами чи обмеженнями в діяльності.

Прихильники цього підходу вважають, що прозорість сприяє відповідальному прийняттю рішень та запобігає неправомірному використанню систем ШІ.

Підзвітність та відповідальність

Зацікавлені сторони повинні нести відповідальність за розробку та використання систем ШІ, а також їх потенційний вплив на людей, суспільство та довкілля. Їм необхідно забезпечити корисне використання технології.

Це включає розгляд етичних наслідків від впровадження ШІ-систем і активну участь у прийнятті рішень протягом усього процесу розробки та розгортання.

Конфіденційність та захист даних

Системи штучного інтелекту часто використовують персональну інформацію, і забезпечення конфіденційності є важливим чинником. Етичні методи ШІ включають отримання згоди на збирання та використання даних. Також необхідно забезпечити контроль над тим, як постачальники послуг розпоряджаються відомостями про користувачів.

Це гарантує дотримання прав на недоторканність приватного життя та захист особистої інформації, вважають експерти.

З цієї причини наприкінці березня 2023 року ChatGPT заблокували в Італії . Місцевий регулятор звинуватив розробників у незаконному збиранні особистих даних, що змусило OpenAI запровадити прозоріші методи роботи.

Ймовірно, щоб не зіткнутися з такими ж проблемами, глобальне розгортання чат-боту Bard компанії Google обійшло стороною не лише ЄС, де дієGDPR, а й весь європейський континент.

Людиноцентричність

Етичний ШІ ставить в основу людиноцентричність. Це означає, що алгоритми необхідно розробляти розширення можливостей людей, а чи не заміну їм.

Принцип включає розгляд потенційного впливу ШІ на робочі місця, соціальну динаміку та загальний добробут, а також забезпечення відповідності технології людським цінностям.

Бізнес та закон

Дотримання етичних норм ШІ — це відповідальна поведінка. Вони також необхідні отримання комерційної вигоди. Питання етики можуть бути бізнес-ризики, такі як невдачі у виробництві продукції, юридичні проблеми або репутаційні збитки бренду.

Теоретично використання алгоритмів стеження за доставниками в Amazon може убезпечити водіїв. Проте працівники виявилися незадоволені зловживанням спостереженням, що викликало галас у ЗМІ, а топ-менеджменту довелося виправдовуватися.

Тим часом Гільдія сценаристів оголосила найбільший за 15 років страйк, частково пов’язаний із поширенням генеративного ШІ. Автори вимагають заборонити або суттєво обмежити використання технології у письменницькій справі та переглянути зарплати.

Чим закінчиться поточний протест, невідомо. Однак стоденний страйк у 2007-2008 роках обійшовся бюджету Каліфорнії у $2,1 млрд.

Однією з причин подібних подій може бути безконтрольний розвиток та використання алгоритмів. Тим не менш, окремі країни і навіть міста застосовують свої власні підходи до моральної сторони питання. Це означає, що компаніям необхідно знати правила ІІ лише на рівні юрисдикції, у межах якої вони здійснюють діяльність.

Яскравими прикладами є положення «Право на пояснення» у GDPR та відповідні розділи Каліфорнійського закону про конфіденційність споживачів.

Деякі американські міста на місцевому рівні ухвалили рішення про обмеження використання алгоритмів. У листопаді 2022 року влада Нью-Йорка заборонила упереджені ШІ-системи для рекрутингу. До цього у місті набула чинності постанова, яка зобов’язує приватні заклади забезпечити конфіденційність біометричних даних відвідувачів.

Етичний ШІ має важливе значення у розробці та впровадженні технологій. Він може забезпечити справедливість, прозорість, конфіденційність та орієнтованість на людину для сприятливого розвитку суспільства.

Крім цього, застосування керівних принципів здатне забезпечити компаніям комерційну вигоду, зокрема запобігаючи занепокоєнню співробітників, споживачів та інших зацікавлених осіб.

Суперечки та дебати навколо ШІ здатні перерости у конструктивний діалог. Надмірне регулювання може перешкодити розвитку технології і погубити потенціал, що не розкрився. Тому зараз існує необхідність пошуку вивірених рішень у галузі етичного використання ІІ, яке задовольнить максимально можливу кількість людей.

Щоб завжди бути в курсі найважливішого, читайте нас у Telegram