Соңғы алты жылда жасанды интеллект технологиясы үлкен танымалдылыққа ие болды. Бұл саладағы оқиғалар біздің күнделікті өмірімізді түбегейлі өзгерте алады. AI төңірегіндегі шудың фонында оның дамуының этикалық салдары туралы да алаңдаушылық бар.

Кейбір сарапшылардың пікірінше, тәуекелдер әлеуетті дезинформациялық шабуылдармен шектелмейді және адам қызметінің барлық дерлік салаларына таралатын генеративті қызметтерден асып түседі.

Басылым ForkLog этикалық АИ және оның қауіпсіздігінің негізгі түсініктерін қарастырды.

- Жасанды интеллект этикасы туралы пікірталас технология пайда болғаннан бері жалғасып келеді.

- Адамдармен өзара әрекеттесетін алгоритмдер жалпы қабылданған мораль стандарттарына сәйкес тәуекелдерге тексерілуі керек.

- Жасанды интеллектті адам интеллектіне ұқсатудың қажеті жоқ.

- Ғалымдар, технологиялық алпауыттар және үкіметтер этикалық АИ-нің негізгі принциптері туралы келіседі.

AI этикасының анықтамасы және терминнің тарихы

Этиканың өзі мораль мен этиканы зерттейтін философиялық пән. Басқаша айтқанда, ол ненің жақсы, ненің жаман екенін түсіндіреді.

Жасанды интеллект этикасы, өз кезегінде, жауапты интеллект принциптерінің жиынтығы — ол не істеу керек және не істеу керек емес. Бұл принциптер көбінесе қауіпсіздікті, әділеттілікті және адамға бағытталғандықты қамтиды.

«Машиналық мораль» тақырыбын алғашқылардың қатарында фантастика жанрында еңбек ететін жазушылар көтерді. Олар өз жұмыстарында роботтардың мінез-құлқы, олардың ақыл-ойы, сезімдері және адамдармен қарым-қатынасы туралы дәлелдеді. Бұл бағыт «робототехника» деп аталды.

Феноменді танымал етуші «Хоровод» повесінің авторы Исаак Азимов болып саналады. Онда жазушы алғаш рет «Робототехниканың үш заңын» тұжырымдаған. Кейінірек «Роботтар мен империя» романында Азимов тізімге нөлдік ережені қосты. Олар келесідей естіледі:

- Робот өз әрекетімен адамзатқа зиян тигізе алмайды немесе әрекетсіздік арқылы адамзатқа зиян тигізуге жол бермейді.

- Робот өз әрекетімен адамға зиян келтіре алмайды немесе әрекетсіздік салдарынан адамға зиян келтіруге жол бере алмайды.

- Бұл бұйрықтар Бірінші Заңға қайшы келетін жағдайларды қоспағанда, робот адам бұйрықтарына бағынуы керек.

- Робот бірінші немесе екінші заңға қайшы келмейтін болса, өз қауіпсіздігін қорғауы керек.

Асимов заңдары танымал болды және оның әдеби шығармаларынан әлдеқайда асып түсті. Оларды әлі күнге дейін жазушылар, философтар, инженерлер мен саясаткерлер талқылайды.

Бірқатар сыншылардың пікірінше, мұндай нормаларды іс жүзінде жүзеге асыру қиын. Жазушы Роберт Сойер бизнестің жергілікті қауіпсіздік шараларын әзірлеуге мүдделі емес екенін айтты.

Алайда трансгуманист Ганс Моравец керісінше пікірде. Оның айтуынша, роботтарды өндірісте қолданатын корпорациялар техникалық процесті басқару үшін осы заңдардың «күрделі аналогын» пайдалана алады.

Асимов тұжырымдаған ережелерді мемлекеттік құрылымдар да пайдаланды. 2007 жылы Оңтүстік Корея үкіметі «Роботтардың этикалық стандарттары туралы ережені» әзірледі. Құжаттың негізгі ережелері жазушы белгілеген постулаттарға ұқсайды.

Роботтардың әскери салада қолданылуына байланысты мәселе өзекті бола бастады. 2021 жылы БҰҰ нысанды өз бетінше анықтап, оны қадағалап, оны жою туралы шешім қабылдаған жасанды интеллект ұшқышсыз ұшқышпен бірінші рет адамның өлімін тіркеді.

GPT немесе DALL-E сияқты генеративті алгоритмдерді танымал еткеннен кейін жасанды интеллект этикасы туралы пікірталастар кеңейді. Үкіметтер ықтимал тәуекелдерді талқылап, AI технологиясын реттеу жоспарларын әзірлеуде, ал технологиялық алыптар қауіпсіз AI жасау үшін ішкі командаларды белсенді түрде дамытуда.

«Троллейбус мәселесі»

Адамдардың өміріне тікелей әсер ететін технологиялардың дамуы бірқатар этикалық және моральдық дилеммаларды тудырады. Оларды ұшқышсыз көліктер мысалында барынша айқын сипаттауға болады: робокар төтенше жағдайда қалай әрекет етуі керек? Жолаушының немесе жаяу жүргіншінің өміріне қауіп төндіре ме?

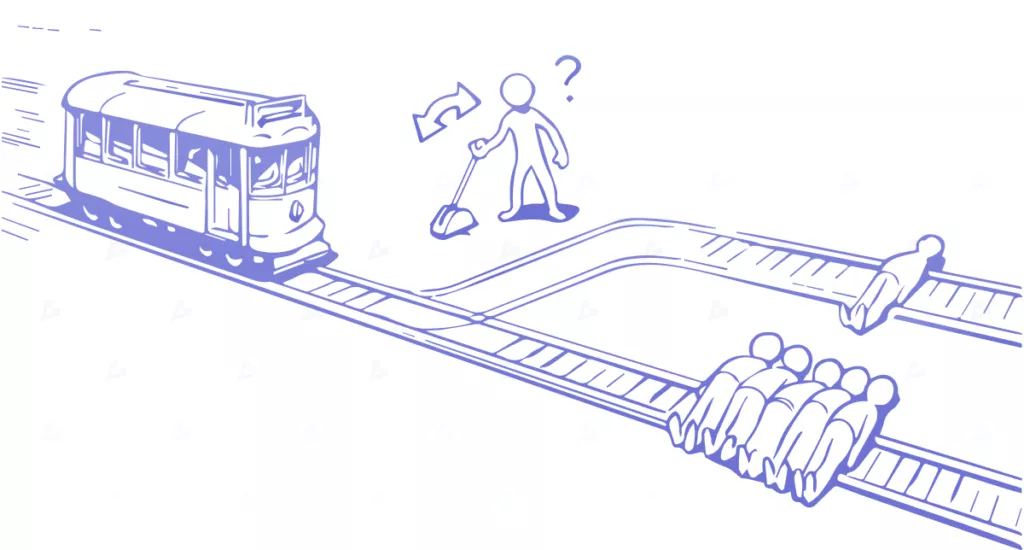

Бұл дилемма 1967 жылы ағылшын философы Филипп Фут тұжырымдаған «троллейбус мәселесі» арқылы жақсы суреттелген. Тапсырманың жалпы мазмұны келесідей:

«Троллейбус басқаруды жоғалтып, темір жол бойымен жылдамдықпен келе жатыр. Алда бес адам байланып, трассада қозғалмайды. Сіз көрсеткі жанында оқиға орнынан белгілі бір қашықтықта тұрсыз. Егер сіз көрсеткіні жылжытсаңыз, троллейбус келесі жол бойымен жүгіреді, бірақ онда бір адам байланған.

Жағдайға әсер ету мүмкіндігіңіз жоқ. Тек екі нұсқа бар: ештеңе істеме, ал арба бес адамды өлтіреді немесе жебені жылжытып, бір өмірді құрбан етеді. Қай нұсқа дұрыс?

Көптеген моральдық принциптерді ұқсас тапсырмаларға қайта пішімдеуге және бірқатар эксперименттерді орындауға болады. Нақты өмірде одан да көп нұсқалар болуы мүмкін, ал оның салдары қайғылы емес. Дегенмен, AI жасаған таңдау өмірге қандай да бір жолмен әсер етеді және барлық тәуекелдерді жоққа шығаруға болмайды.

AI адамдардан үйренбеуі керек

Моральдық-этикалық принциптерді адам қалыптастырғанына қарамастан, АИ адамдар сияқты болмауы керек, өйткені қоғамға тән біржақтылық алгоритмге еніп кетуі мүмкін.

Бұл бетті тану технологиясы арқылы жақсы суреттелген. Тиісті жүйелерді құру үшін адамдардың бейнесі бар деректердің үлкен жинағы жиналады. Көбінесе процесс үлгі алуандығы мен контекстті ескермейтін автоматтандырылған боттармен басқарылады. Нәтижесінде деректер жинағы бастапқыда біржақты болып көрінуі мүмкін.

Дамудың келесі кезеңі - үлгі құру және оқыту. Қиындықтар мен бұрмалаулар осы кезеңде, соның ішінде «қара жәшік» мәселесі арқылы да енуі мүмкін. Инженерлер алгоритм неліктен осы немесе басқа шешім қабылдайтынын білмейді.

Біржақтылық тәуекелдері тек түсіндіру деңгейінде болады. Дегенмен, бұл кезеңде адам қазірдің өзінде үлкен рөл атқарады. Мысалы, алгоритм белгілі бір адамдар үлгісінде оқытылып, нақты нәтижелерге ие болды. Содан кейін олар жүйені басқа топқа қолданды — деректер күрт өзгерді.

2021 жылы голландиялық белсенділер әлеуметтік көмекті бөлу жүйесінде бұрмаланулардың бар екенін дәлелдеді. Олардың айтуынша, оны пайдалану адам құқықтарын бұзған. Нәтижесінде муниципалды билік бағдарламалық жасақтаманы пайдаланудан бас тартты.

Сондай-ақ әзірлеушілер деректерді тасымалдау мәселесі туралы хабарлайды. 2023 жылдың наурыз айында зерттеушілер тобы ұйқы безінің қатерлі ісігінің қаупін болжайтын алгоритмді әзірледі. Жүйені оқыту үшін зерттеушілер негізінен Даниялық клиникалардағы науқастардың медициналық жазбаларын пайдаланды.

Ғалымдар АҚШ-тан келген пациенттерді жобалау кезінде алгоритмнің дәлдігі айтарлықтай төмендейтінін ескертті. Осыған байланысты алгоритмді американдықтардың деректері бойынша қайта даярлау керек.

Этикалық АИ-нің танымал принциптері

Зерттеу топтары, адам құқықтарын қорғаушылар, технологиялық алпауыттар мен үкіметтер әртүрлі тәсілдер ұсынады, бірақ олардың барлығында бірқатар ұқсастықтар бар. Ең танымал пікірлерді қарастырайық.

Әділдік және кемсітушілік

Жасанды интеллект жүйелері нәсіліне, жынысына, дініне немесе басқа қорғалатын сипаттарға негізделген кемсітуді азайтуға арналған. Алгоритмдердегі ауытқулар бар теңсіздіктерді күшейтіп, белгілі бір топтарға зиян келтіруі мүмкін.

Мысалы, бет-әлпетті тану жүйелері белгілі бір нәсілдік және гендерлік топтар үшін қателіктердің жоғарырақ болуымен олардың дәлдігінде ауытқушылық көрсетті. 2019 жылы Нью-Джерси штатының (АҚШ) қара нәсілді тұрғыны алгоритм қателігіне байланысты 10 күн түрмеде отырды. Мұндай жағдайлар басқа қалаларда да орын алды, олар үшін бейтарап технологияларды қолдану салдарынан полиция сын толқынына тап болды.

Этикалық AI әдістері шешім қабылдауда әділеттілікке ықпал ете отырып, мұндай қисындылықты анықтауға және азайтуға көмектеседі.

Мөлдірлік пен айқындық

Айқындық пен түсіністік AI-ға деген сенімді қалыптастыру үшін маңызды. Жүйелер олардың шешімдер қабылдау процестері мен нәтижелері барлық мүдделі тараптарға түсінікті болатындай етіп жасалуы керек.

Генеративті жүйелерді әзірлеушілер алгоритмдер арқылы жасалған мазмұнды белгілеу үшін су белгілерін пайдалану мүмкіндігін қарастыруда. Олар бұл пайдаланушылардың хабардар болуын арттырады және жалған ақпараттың таралуын болдырмайды деп санайды.

AI-ны ашық пайдаланудың тағы бір мысалы - Иллинойс штатының (АҚШ) биометриялық деректердің құпиялылығына қатысты заңы. Құжат компанияларға пайдаланушыларға нақты ескертпестен тұлғаны тану сияқты технологияларды пайдалануға тыйым салады.

Google және Clearview AI сияқты компаниялар қазірдің өзінде заңға сәйкес бірнеше миллион долларлық айыппұлдарға немесе бизнес шектеулеріне тап болды.

Бұл тәсілді жақтаушылар ашықтық жауапты шешім қабылдауға ықпал етеді және AI жүйелерін теріс пайдаланудың алдын алады деп санайды.

Жауапкершілік пен жауапкершілік

Мүдделі тараптар AI жүйелерін әзірлеу және пайдалану және олардың адамдарға, қоғамға және қоршаған ортаға ықтимал әсері үшін жауапкершілікті өз мойнына алуы керек. Олар технологияны тиімді пайдалануды қамтамасыз етуі керек.

Бұған AI жүйелерін енгізудің этикалық салдарын қарастыру және бүкіл әзірлеу және енгізу үдерісінде шешім қабылдауға белсенді қатысу кіреді.

Құпиялылық және деректерді қорғау

Жасанды интеллект жүйелері жеке ақпаратты жиі пайдаланады және құпиялылықты қамтамасыз ету маңызды фактор болып табылады. Этикалық AI тәжірибесі деректерді жинау және пайдалану үшін келісім алуды қамтиды. Сондай-ақ қызмет провайдерлерінің пайдаланушы ақпаратын қалай кәдеге жарататынын бақылауды қамтамасыз ету қажет.

Бұл сарапшылардың пікірінше, құпиялылық және жеке ақпаратты қорғау құқықтарының сақталуын қамтамасыз етеді.

Осы себепті ChatGPT Италияда 2023 жылдың наурыз айының соңында бұғатталды. Жергілікті реттеуші әзірлеушілерді жеке деректерді заңсыз жинады деп айыптады, бұл OpenAI-ді ашық жұмыс әдістерін енгізуге мәжбүр етті.

Бірдей проблемаларды болдырмау үшін Google-дың Bard чат-ботының жаһандық шығуы GDPR қолданылатын ЕО-ны ғана емес, бүкіл Еуропа континентін айналып өтті.

Адамдарға бағдарлану

Этикалық AI адамға бағытталғандыққа негізделген. Бұл алгоритмдерді адамдардың мүмкіндіктерін арттыру үшін емес, оларды алмастыру үшін жасау керек дегенді білдіреді.

Принцип жұмыс орындарына, әлеуметтік динамикаға және жалпы әл-ауқатқа АИ-нің ықтимал әсерін қарастыруды, сондай-ақ технологияның адами құндылықтарға сәйкес келуін қамтамасыз етуді қамтиды.

Бизнес және құқық

AI этикасын ұстану - бұл жауапты мінез-құлық. Олар коммерциялық пайда үшін де қажет. Этикалық мәселелер өнім ақаулары, заңды мәселелер немесе бренд беделіне нұқсан келтіру сияқты іскерлік тәуекелдер болуы мүмкін.

Теориялық тұрғыдан Amazon жеткізуді қадағалау алгоритмдерін қолдану драйверлердің қауіпсіздігін қамтамасыз ете алады. Алайда, БАҚ-та шу тудырған бақылаудың теріс пайдаланылуына қызметкерлер наразы болып, жоғарғы басшылық сылтау айтуға мәжбүр болды.

Сонымен қатар, Сценаристер Гильдиясы генеративті AI-ның таралуына байланысты 15 жылдағы ең үлкен ереуілін жариялады. Авторлар жазбаша түрде технологияны пайдалануға тыйым салуды немесе айтарлықтай шектеуді және жалақыны қайта қарауды талап етеді.

Қазіргі наразылықтың немен аяқталатыны белгісіз. Алайда 2007-2008 жылдардағы 2,1 күндік ереуіл Калифорния бюджетіне XNUMX миллиард доллар шығын әкелді.

Мұндай оқиғалардың себептерінің бірі алгоритмдерді бақылаусыз әзірлеу және пайдалану болуы мүмкін. Дегенмен, жекелеген елдер, тіпті қалалар мәселенің моральдық жағына өз көзқарастарын қолданады. Бұл компаниялар тек олар жұмыс істейтін юрисдикция деңгейінде II ережелерді білуі керек дегенді білдіреді.

Айқын мысалдар ережелер болып табылады «Түсіндіру құқығы» GDPR және Калифорния тұтынушыларының құпиялылығы туралы заңның тиісті бөлімдерінде.

Жергілікті деңгейдегі кейбір американдық қалалар алгоритмдерді пайдалануды шектеу туралы шешім қабылдады. 2022 жылдың қарашасында Нью-Йорк қаласы AI жалдау жүйелеріне тыйым салды. Бұған дейін қалада жекеменшік мекемелерге келушілердің биометриялық деректерінің құпиялылығын қамтамасыз етуді міндеттейтін қаулы күшіне енген болатын.

Этикалық AI технологияны әзірлеу мен енгізуде маңызды. Ол қоғамның қолайлы дамуы үшін әділдікті, ашықтықты, құпиялылықты және адамға бағдарлануды қамтамасыз ете алады.

Сонымен қатар, нұсқаулықтарды қолдану компанияларға коммерциялық артықшылықтар бере алады, атап айтқанда, қызметкерлер, тұтынушылар және басқа да мүдделі тараптар арасындағы алаңдаушылықтың алдын алу арқылы.

Жасанды интеллект төңірегіндегі қайшылықтар мен пікірталастар конструктивті диалогқа айналуы мүмкін. Шамадан тыс реттеу технологияның дамуына кедергі келтіруі және пайдаланылмаған әлеуетті жоюы мүмкін. Сондықтан қазіргі уақытта АИ-ді этикалық қолдану саласында дәлелденген шешімдерді табу қажет, ол адамдардың максималды санын қанағаттандырады.

Әрқашан ең маңызды нәрселерден хабардар болу үшін бізді мына жерден оқыңыз Telegram